Hybridation de méthodes

complètes et incomplètes pour la

résolution de CSP

Thèse de doctorat

Spécialité : Informatique

École Doctorale STIM

Sciences et Technologies de l’Information et des MatériauxPrésentée et soutenue publiquement

| Le | 27 Octobre 2006 |

| À | Nantes |

| Par | Tony LAMBERT |

Devant le jury ci-dessous :

| Président : | Jin-Kao Hao, | Professeur à l’Université d’Angers |

| Rapporteurs : | François Fages | Directeur de Recherche, INRIA Rocquencourt |

| | Bertrand Neveu, | Ingénieur en Chef des Ponts et Chaussées, HDR |

| Examinateurs : | Steve Prestwich, | Maître-assistant à l’Université de Cork |

| Directeurs de thèse : | Éric Monfroy, | Professeur à l’Université de Nantes |

| Frédéric Saubion, | Professeur à l’Université d’Angers |

Sommaire

Part I Méthodes de résolution des problèmes de satisfaction de contraintes

1 Les problèmes de satisfaction de contraintes

1.1 Introduction

1.2 Le modèle CSP et ses principales caractéristiques

1.3 Les problèmes d’optimisation sous contraintes

1.4 Exemples de formalisation

1.4.1 Le problème du coloriage de carte

1.4.2 Le placement de reines

1.4.3 Le problème du Zèbre

1.4.4 La règle de Golomb

1.4.5 Les carrés magiques

1.4.6 SEND + MORE = MONEY

1.4.7 Le nombre de Langford

1.4.8 Le voyageur de commerce

1.5 Conclusion

2 Résolution des CSP par des méthodes complètes

2.1 Introduction

2.2 Generate-and-test et backtracking

2.3 Notion de consistance

2.3.1 Consistance de noeud

2.3.2 Consistance d’arc

2.3.3 Consistance hyper-arc

2.3.4 La k-consistance

2.4 Algorithmes de filtrage et propagation de contraintes

2.4.1 Les contraintes globales

2.5 Méthodes de recherche et algorithmes de résolution

2.6 Conclusion

3 Résolution des CSP par des méthodes incomplètes

3.1 Introduction

3.2 La recherche locale

3.2.1 Recherche par voisinage

3.2.2 Algorithmes de recherche locale

3.3 Les algorithmes génétiques

3.4 Conclusion

4 Résolution hybride

4.1 Introduction

4.2 Approches Collaboratives

4.3 Approche intégrative

4.3.1 La recherche locale au secours de l’algorithme complet

4.3.2 Une méthode complète au c ur du voisinage d’une recherche locale

4.4 Conclusion

5 Cadre et algorithme générique pour la propagation de contrainte

5.1 Introduction

5.2 Ordre partiel

5.3 Fonctions et propriétés

5.4 Application aux CSP et domaines composés

5.5 Algorithme générique itératif

5.6 Conclusion

II Cadre théorique uniforme pour la résolution des CSP

6 Introduction de la recherche locale

6.1 Introduction

6.2 Échantillons et voisinage

6.2.1 Échantillonnage et Notion de solution

6.2.2 Ordre sur les échantillons

6.3 Modèle de calcul

6.4 Les solutions

6.5 Fonctions de réduction : définition et propriétés

6.5.1 Réduction de domaines

6.5.2 Découpage de domaines

6.5.3 Le Recherche locale

6.6 La résolution d’un sCSP

6.6.1 Les fonctions de sélection

6.6.2 Réduction de domaine

6.6.3 Découpage

6.6.4 La recherche locale

6.6.5 Exemple de mouvement de recherche locale

6.6.6 Combinaison

6.6.7 Résultat de l’algorithme GI

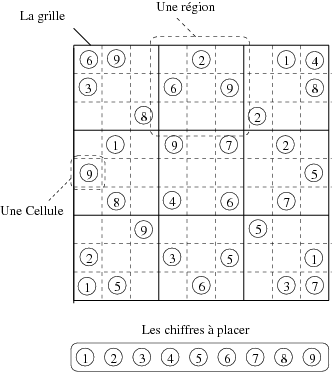

6.7 Application du modèle de recherche locale pour le Sudoku

6.7.1 Le modèle CSP

6.7.2 Les fonctions

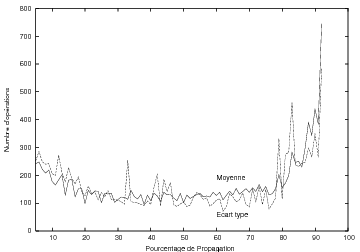

6.7.3 Résultats expérimentaux

6.8 Application du modèle pour une hybridation CP+LS

6.8.1 Fonctions et stratégies

6.8.2 Résultats expérimentaux

6.9 Conclusion

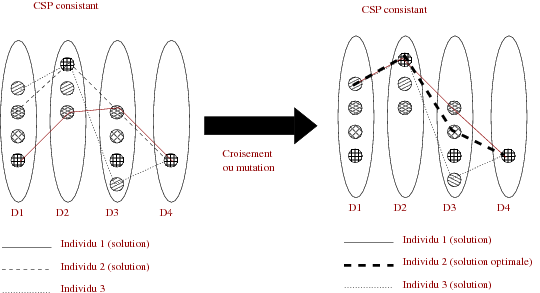

7 Modèle hybride pour les algorithmes génétiques

7.1 Introduction

7.2 Algorithme génétique et population

7.2.1 Populations

7.2.2 Ordre sur les individus, ordre sur les populations

7.2.3 Structure de calculs

7.2.4 Les solutions

7.2.5 Un système à base de fonctions

7.2.6 La résolution sGCSP

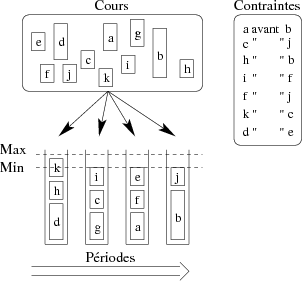

7.3 CP+AG pour les problèmes d’optimisation

7.3.1 Instances du problème

7.3.2 Processus expérimental

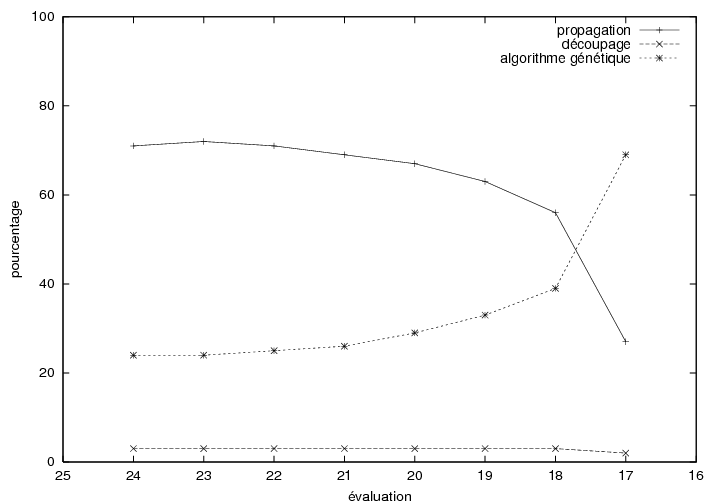

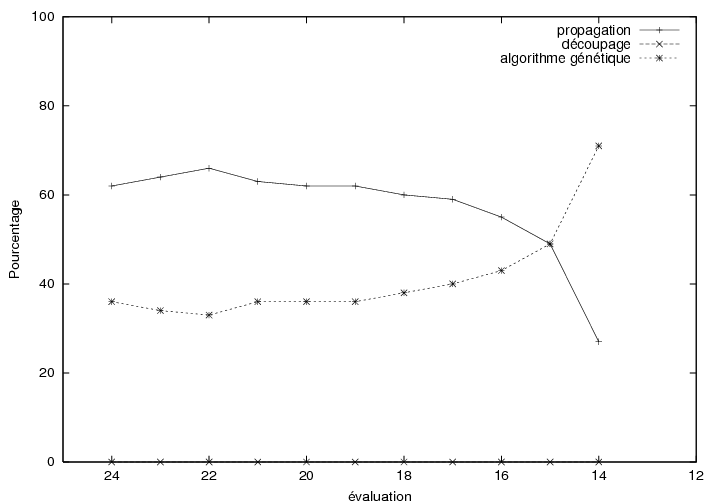

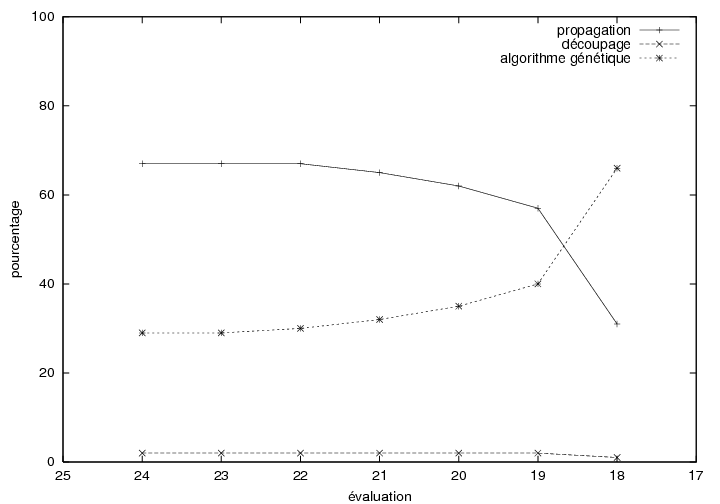

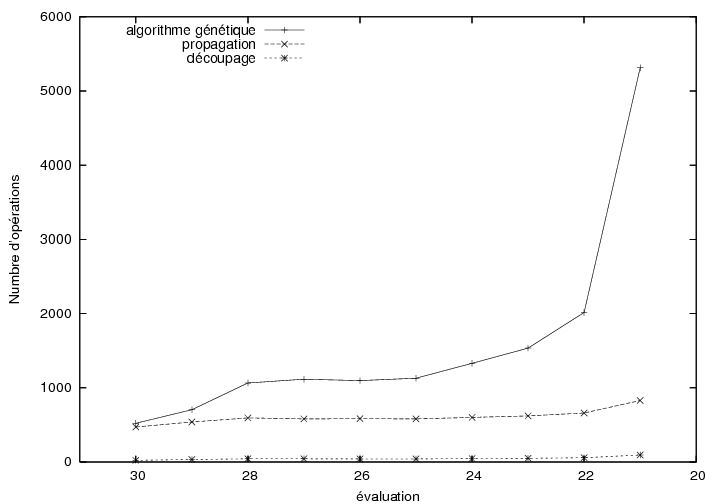

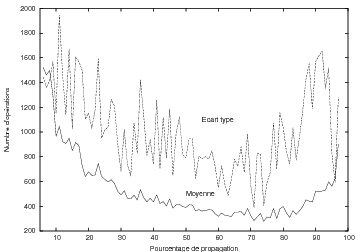

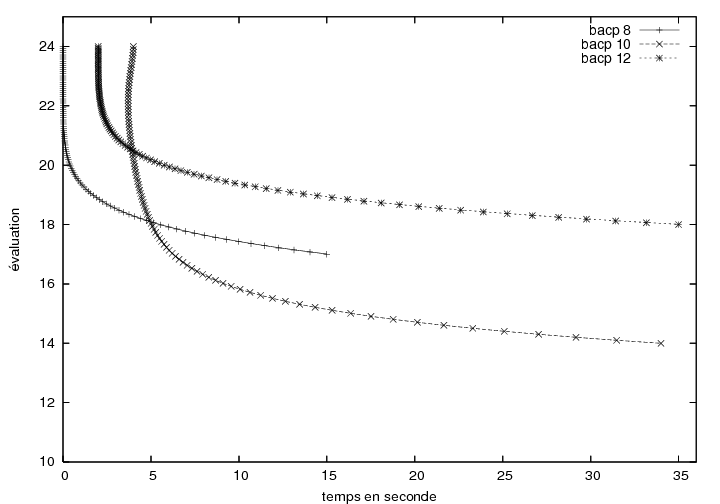

7.3.3 Résultats expérimentaux

7.4 Conclusion

8 Une formulation hybride des CSP

8.1 Introduction

8.2 Un système hybride pour les CSP

8.2.1 Construction d’un ordre partiel

8.2.2 Fonctions de réduction de domaines

8.2.3 Échantillonnage

8.2.4 Réduire

8.3 Fonction de réduction

8.3.1 La réduction de domaine

8.3.2 Le découpage

8.3.3 La recherche locale

8.3.4 L’évolution

8.4 Conclusion

Introduction Générale

Contexte de travail

La famille des problèmes de satisfaction de contraintes [ Tsang1993, Waltz1975] (Constraint Satisfaction Problems CSP) couvre un grand nombre de problèmes pratiques (planification, ordonnancement, emploi du temps ...) dont de nombreux exemples ont été recensés et catalogués depuis plusieurs décennies (le lecteur pourra consulter, en autres, la CSPLib [ Gent et al. ]). D’un point de vue calculatoire, les problèmes considérés induisent bien souvent des complexités algorithmiques élevées puisque bon nombre d’entre eux relèvent de la classe des problèmes NP-complets [ Garey and Johnson1978, Papadimitriou1994]. Ces problèmes partagent une structure de description commune, basée sur un formalisme très simple, qui autorise une modélisation claire et intuitive. Plus précisément, étant donné un ensemble de n variables X={x1,...,xn} dont les domaines de valeurs respectifs sont dans l’ensemble D={D1,...,Dn} (nous considérons dans cette thèse des domaines discrets), une contrainte quelconque est une relation c ⊆ D1×...×Dn. Un CSP est alors classiquement défini par un triplet (X,D,C) où C est l’ensemble des contraintes. Une solution correspond à une affectation de valeurs aux variables qui satisfait les contraintes et les restrictions imposées par les domaines. On distingue alors les problèmes satisfiables, possédant au moins une solution, et les problèmes insatisfiables. En terme de résolution opérationnelle, plusieurs voies peuvent être envisagées selon que l’on s’intéresse à décider de l’existence d’une solution, à son calcul effectif ou encore au calcul exhaustif de l’ensemble des solutions. Au cours des vingt dernières années, de nombreux algorithmes et systèmes ont été développés pour résoudre les CSP. Classiquement, on identifie deux grandes familles au sein de ces techniques de résolution. D’une part, les méthodes complètes (ou exactes), dont l’objectif est de répondre au problème de décision et donc de prouver la satisfiabilité d’un problème, ou son insatisfiabilité le cas échéant. En général, ces méthodes permettent également d’extraire l’ensemble des solutions d’un problème. D’autre part, les méthodes incomplètes (ou approchées) abordent généralement la résolution d’un CSP comme un problème d’optimisation combinatoire pour lequel il s’agit de calculer une affectation satisfaisant le plus grand nombre de contraintes, l’objectif final étant de les satisfaire toutes. Dans ce cas, on parle aussi de problème de satisfiabilité maximale (MaxCSP) 1. Contrairement aux approches complètes, les méthodes incomplètes ne peuvent pas conclure à l’insatisfiabilité d’un problème. Du point de vue des techniques utilisées, les approches complètes reposent principalement sur une recherche arborescente incluant des notions de consistance locale des contraintes [ Mackworth1992, Mohr and Henderson1986]. Un arbre de recherche permet la construction incrémentale d’affectations, attribuant, à chaque noeud, des valeurs aux variables et testant progressivement la validité des choix effectués vis-à-vis des contraintes. Afin de réduire l’espace de recherche, on utilise généralement la structure et les propriétés de ces contraintes pour élaguer l’arbre ainsi que diverses stratégies de construction et de parcours. Ces techniques sont à la base des systèmes de programmation par contraintes (on pourra se reporter par exemple à [ van Hentenryck1989, Fages1996, Mariott and Stuckey1998, Fruewirth and Abdennadher2003, Dechter2003] pour plus de précisions) concrétisés par de nombreux langages et solveurs (Prolog IV [ Colmerauer1994], Chip [ Aggoun and Beldiceanu1991], Ilog Solver [ ILOG2000], CHOCO [ Laburthe2000]...). Rappelons que la programmation par contraintes a connu ses premiers succès au travers de la programmation logique avec contraintes, paradigme au sein duquel la programmation logique sert de langage hôte pour la formulation du problème et des contraintes [ Jaffar and Lassez1987, Fages1996, Colmerauer1990]. Les approches incomplètes reposent, quant à elles, essentiellement sur l’utilisation d’heuristiques [ Aarts and Lenstra1997, Hao et al. 1999] et particulièrement d’algorithmes basés sur la recherche locale. L’objectif de ces approches est d’explorer l’espace de recherche (dans le cas des CSP, l’ensemble des affectations possible) au moyen d’heuristiques plus ou moins sophistiquées et ce, afin d’en extraire au plus vite une solution. Deux grandes notions sont alors mises en oeuvre. D’un côté, l’intensification consiste à fouiller une zone précise de l’espace afin d’en extraire un optimum local ou mieux, une solution. D’un autre côté, la diversification a pour but de déplacer la recherche dans des zones variées de l’espace. L’efficacité d’une méthode incomplète réside alors dans l’alternance de ces deux phases, gérées au moyen de diverses structures et stratégies, ce qui a donné naissance à la famille des méthodes dites métaheuristiques. Au sein de cette famille, nous distinguerons deux grandes classes qui seront utilisées dans le cadre de nos travaux. D’un côté, les méthodes de recherche locale explorent l’espace de recherche de proche en proche, se déplaçant d’une affectation vers une affectation voisine, guidées par une fonction évaluation (correspondant, par exemple, au nombre de contraintes violées). Divers algorithmes ont alors été proposés [ Kirkpatrick et al. 1983, Glover and Laguna1997, Aarts and Lenstra1997], introduisant des techniques de contrôle afin de garantir un équilibre entre diversification et intensification et une efficacité globale de résolution. Afin de faciliter la conception et l’utilisation de tels algorithmes pour les CSP, on dispose également de bibliothèques spécialisées, telles que EasyLocal++ [ Gaspero and Schaerf2003] mais également de langages dédiés tels que Localizer [ Michel and Hentenryck1997] ou plus récemment Comet [ van Hentenryck and Michel2005]. D’un autre côté, nous trouvons la classe des algorithmes évolutionnistes [ Holland1975b, Goldberg1989b, Michalewicz1996] qui gèrent un ensemble de configurations d’un problème et les font évoluer dans le but d’atteindre une solution. Les mécanismes opérationnels s’inspirent du principe de l’évolution naturelle et, au-delà de cette métaphore, ces méthodes se sont avérées très utiles pour la résolution de problèmes combinatoires complexes (conférences GECCO, PPSN, CEC et EvoCOP). Lorsqu’il s’intéresse à l’utilisation effective de toutes ces méthodes, l’utilisateur se trouve confronté à un dilemme. En effet, si les méthodes complètes présentent davantage de garanties en terme de résultats (preuve d’insatisfiabilité, obtention possible de l’ensemble des solutions), elles trouvent toutefois leurs limites avec l’augmentation de la taille et de la complexité des problèmes considérés. En effet, en particulier dans le cas de problèmes NP-complets, l’explosion combinatoire de l’espace de recherche induit un coût de calcul prohibitif. Dans cas, mais au détriment de la complétude de la résolution, l’utilisateur peut alors se tourner vers les méthodes incomplètes qui ont prouvé leur efficacité en terme de passage à l’échelle. Dans ce contexte, de nouveaux langages et systèmes, tels que le langage Salsa [ Laburthe and Caseau2002], permettent à l’utilisateur de spécifier des algorithmes de recherche globale ou locale, ou encore des algorithmes hybrides. Un très grand nombre de travaux ont été menés sur l’hybridation entre des approches complètes et des méthodes métaheuristiques, en particulier entre programmation par contraintes et recherche locale (citons par exemple [ Jussien and Lhomme2002, Prestwich2000, Pesant and Gendreau1996, Shaw1998]). On pourra se reporter à [ Focacci et al. 2002] pour un panorama plus général. Ces algorithmes, hybridant recherche locale et techniques d’exploration complètes, correspondent souvent à des réponses spécifiques dédiées à des problèmes particuliers. On peut distinguer deux grands types de combinaison au sein de ces algorithmes selon que :- la recherche locale vise à améliorer un algorithme complet : à certains n uds de l’arbre de recherche construit par la méthode complète, une recherche locale est utilisée afin d’atteindre une solution à partir d’une affectation partielle ou bien encore afin d’améliorer une affectation donnée. La recherche locale peut également être envisagée comme outil de réparation.

ou, inversement que

- les méthodes complètes servent à guider la recherche locale : la propagation de contraintes est utilisée pour réduire le voisinage d’un point ou l’espace de recherche dans sa totalité. Les techniques complètes peuvent aussi servir à explorer le voisinage d’un point pour déterminer le prochain mouvement à effectuer lors du processus de recherche locale.

Notons que d’autres travaux combinent par ailleurs algorithmes évolutionnaires et programmation par contraintes [ Madeline2002, Riff Rojas1996, Tam and Stuckey1999]. Ces approches, si différentes qu’elles soient, partagent souvent une même philosophie dans leur conception : un mécanisme est considéré comme le processus maître de la recherche et les autres techniques viennent à son aide comme autant d’heuristiques améliorant ses performances. De ce fait, un tel schéma général rend difficile une réelle coopération entre les différentes approches. Toutefois, les résultats obtenus par les approches hybrides nous poussent de plus en plus à nous tourner vers ce type de démarche pour concevoir des solveurs de plus en plus efficaces, tirant profit de avantages respectifs des méthodes combinées.

Motivations et contributions

Finalement, l’ensemble des techniques que nous venons de décrire est vaste, leurs principes fondamentaux de résolution sont très variés et leurs propriétés diverses. De plus, ces méthodes sont formulées de manières très hétérogènes : algorithmes dédiés, stratégies, propriétés, systèmes plus ou moins génériques ... Il peut donc s’avérer complexe de comprendre précisément leur fonctionnement et d’identifier leurs propriétés afin de bénéficier au mieux de leurs atouts. La nécessité de disposer d’un cadre formel, permettant de décrire et de caractériser les processus opérationnels de ces techniques, se faisait donc réellement sentir. Dans le contexte de la résolution des CSP par des solveurs complets, K. Apt a proposé une formalisation des opérations de réduction des domaines des variables au moyen des propriétés de consistance locale en terme de calcul de point fixe d’un ensemble de fonctions sur une structure ordonnée [ Apt1997, Apt1999, Apt2003]. Dans ce modèle, on itère un ensemble d’opérateurs qui abstraient la structure des contraintes. Ce cadre formel permet de mettre en avant les propriétés principales de ces mécanismes de résolution (convergence et terminaison). Dès lors, en nous basant sur ces travaux, nous avons décidé de les étendre pour prendre en compte un ensemble plus large de techniques de résolution et, en particulier, les méthodes incomplètes. L’objectif d’un tel travail est de permettre une intégration plus homogène de ces paradigmes de résolution afin d’en faciliter la combinaison dans le cadre d’algorithmes de résolution hybrides. Nous avons donc proposé un nouveau cadre basé sur la notion d’itérations chaotiques de fonctions sur un ordre partiel, étendant ainsi les travaux de K. Apt. Ce cadre permet de modéliser de manière uniforme la résolution des CSP par des méthodes complètes (filtrage des domaines des variables, propagation de contraintes et découpe des domaines) et par des méthodes incomplètes (recherche locale et algorithmes génétiques). Nous pouvons alors abstraire les structures et les mécanismes effectifs de la résolution, autorisant ainsi des combinaisons plus homogènes entre les processus. Nous sommes également en mesure de caractériser plus clairement le déroulement et les résultats des processus de résolution hybrides et définir leurs principales propriétés. Enfin, ce cadre peut servir de base au prototypage et à la définition de nouvelles stratégies de résolution et de coopération entre les méthodes. Afin de mettre en avant les atouts de ce nouveau formalisme, nous avons développé un système qui intègre les principaux composants que nous avons définis de manière formelle et permet, au travers d’un algorithme générique, de simuler des stratégies de résolution hybrides variées. Nous présenterons donc un certain nombre de résultats expérimentaux obtenus sur divers jeux d’essai, qui permettent de souligner les atouts et avantages d’une résolution hybride des CSP. Le document s’articule de la manière suivante.Organisation de la thèse

Le manuscrit se décompose en deux parties. La première présente l’état de l’art des méthodes de résolution de CSP. Nous rappelons tout d’abord les notations et les principales caractéristiques d’une modélisation en CSP ainsi que des exemples. Ensuite, la résolution par des méthodes complètes est décrite, introduisant les notions de consistances, de filtrage, de propagation et les algorithmes en faisant usage. Puis, nous présentons la résolution par les méthodes incomplètes, de la recherche locale aux algorithmes génétiques. Après un survol des hybridations existantes entre ces méthodes par collaboration ou intégration, nous présentons le cadre formel proposé par K. Apt pour une modélisation de la propagation de contraintes sur une structure ordonnée. La seconde partie est consacrée à l’extension des travaux de K. Apt pour l’hybridation des méthodes complètes et incomplètes. Nous introduisons tout d’abord la notion d’échantillon qui nous permet par la suite une intégration de la recherche locale au sein d’un modèle hybride. Ce modèle est alors mis en uvre dans diverses expérimentations. Ensuite, nous proposons un cadre pour l’hybridation des algorithmes génétiques et des méthodes complètes pour une application à des problèmes d’optimisation sous contraintes. Enfin, dans un dernier chapitre, nous présentons un cadre général et uniforme des notions vues précédemment avant une conclusion générale qui résumera nos contributions et ouvrira sur des différentes perceptives de recherches.

Part 1

Méthodes de résolution des

problèmes de satisfaction

de contraintes

Chapitre 1

Les problèmes de satisfaction

de contraintes

| Dans ce chapitre, nous présenterons les principales notions liées aux problèmes de satisfaction de contraintes (Constraint Satisfaction Problem CSP) qui sont au c ur de cette thèse. Des exemples de problèmes sous forme CSP illustrent le formalisme. |

1.1 Introduction

Beaucoup de problèmes issus de l’Intelligence Artificielle (IA)

ainsi que d’autres branches de l’informatique peuvent être

modélisés comme des problèmes de satisfaction de contraintes (CSP)

[ Nadel1990]. Nous trouvons des exemples en conception de

scènes en 3D [ Chakravarthy1979, Davis and Rosenfeld1981], en maintien de la

cohérence [ Dechter1987, Dechter and Dechter1988, Croker and Dhar1993], en

ordonnancement

[ Dhar and Ranganathan1990, Fox1987, Fox et al. 1989, Petrie et al. 1989, Prosser1989, Rit1986],

en raisonnement temporel

[ Allen1983, Allen1984, Dechter et al. 1991, Vilain and Kautz1986, Tsang1987], en théorie des

graphes [ McGregor1979, Bruynooghe1985], en architecture

[ Eastman1972], en planification d’expérimentations génétiques

[ Stefik1981], en conception de circuit

[ de Kleer and Syssman1980], en conception et fabrication de machines

[ Frayman and Mittal1987, Navinchandra1991], ou encore en raisonnement

diagnostique [ Geffner and Pearl1987]. La modélisation d’un problème

sous forme de CSP se révèle souvent souvent pratique et intuitive.

Dans ce qui suit nous rappellerons les notations, les définitions

liées à ce formalisme ainsi que des exemples de son utilisation.

1.2 Le modèle CSP et ses principales caractéristiques

Un problème de satisfaction de contraintes (CSP) est généralement présenté sous la forme d’un ensemble de variables, auxquelles sont associés des domaines, ainsi qu’un ensemble de contraintes. Chaque contrainte est définie sur un sous-ensemble de l’ensemble des variables et limite les combinaisons de valeurs que peuvent prendre ces variables. La résolution d’un CSP consiste à trouver une affectation de valeur pour chaque variable de telle sorte que l’ensemble des contraintes soit satisfait. Pour certains problèmes, le but est de trouver toutes ces affectations. Nous allons par la suite présenter non pas le cadre général, mais nous restreindre à des domaines finis de valeurs discrètes. Cette limitation se traduit dans les exemples présentés et, nous verrons par la suite, se justifie par des expérimentations pour des problèmes à domaines finis. Définition 1 [Problème de satisfaction de contraintes] Un problème de satisfaction de contraintes (CSP) [ Tsang1993] est défini par un triplet (X,D,C) où:

- X = { x1,..., xn} est l’ensemble fini des n variables du problème,

- D = {Dx1,...,Dxn} est l’ensemble des n domaines finis pour les variables. Dxi est l’ensemble des valeurs possibles pour la variable xi,

- C = {c1,...,cm} est l’ensemble des m contraintes.

|

- unaire si son arité est égale à 1,

- binaire si son arité est égale à 2,

- n-aire si son arité est égale à n.

| Exemple (CSP simple) : |

Nous pouvons, par exemple, définir un problème

simple sous forme de CSP (X,D,C) avec :

|

Étant donné un CSP (X,D,C), sa résolution consiste à affecter des valeurs aux variables, de telle sorte que toutes les contraintes soient satisfaites. On introduit pour cela les notations et définitions suivantes. Définition 4 [Affectation] Soit un CSP (X,D,C), on appelle affectation le fait d’instancier certaines variables par des valeurs (prises dans leurs domaines respectifs). Une affectation est une fonction :

|

|

|

A chaque CSP P = (X, D, C) peut être associé, pour les contraintes binaires, un graphe des contraintes (ou graphe associé) obtenu en représentant chaque variable du réseau par un sommet et chaque contrainte binaire qui porte sur les variables xi et xj, notée cij ∈ C par une arête entre les sommets xi et xj. Dans le cas des CSP à avec des contraintes n-aires, on peut utiliser la représentation par hyper-graphe, en remplaçant les arêtes par des hyper-arêtes. Le graphe des contraintes permet d’avoir un rendu graphique du problème ; il se trouve ainsi être parfois l’intermédiaire entre le problème réel et sa transcription dans le formalisme CSP. C’est le cas par exemple pour le problème de coloriage de graphe qui sera présenté dans la section suivante.

1.3 Les problèmes d’optimisation

sous contraintes

Un problème d’optimisation sous contraintes consiste à trouver une

solution optimale parmi l’ensemble des solutions réalisables (i.e

qui ne violent pas de contraintes). Le problème est alors double,

nous avons : d’une part une recherche des solutions réalisables et

d’autre part une recherche d’une solution optimale. Une fonction,

appelée fonction objectif, est définie selon le problème posé pour

évaluer la qualité d’une affectation. Cette fonction associe à

chaque instanciation une valeur, l’objectif est alors de trouver

l’affectation qui minimise ou maximise cette fonction.

Définition 8 [Problème d’optimisation sous contraintes]

Étant donné un CSP P = (X,D,C), notons S

l’espace de recherche défini par les domaines de D.

Soit (K, < ) avec K un ensemble totalement

ordonné par la relation stricte < et f une fonction de coût,

aussi appelé fonction objectif de S vers K :

|

|

1.4 Exemples de formalisation

Comme suggéré en début de chapitre, une multitude de problèmes se modélisent sous forme de CSP. Dans ce qui suit nous rappellerons des problèmes simples, i.e., académiques.

1.4.1 Le problème du coloriage

de carte

Le problème de coloriage de carte, cas spécial du coloriage de graphe, peut se modéliser sous forme de CSP. Dans ce

problème, nous devons colorier (avec un ensemble de couleurs

donné) chaque région d’une carte, c’est à dire d’un graphe

planaire, de telle manière que deux régions adjacentes n’aient pas

la même couleur.

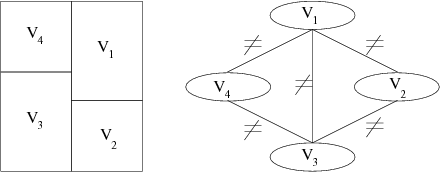

La figure 1.1 montre un exemple de problème du

coloriage de carte et son équivalent CSP sous la forme du graphe

des contraintes. La carte comporte quatre régions devant être

coloriées en rouge, bleu ou vert. Le CSP équivalent a une variable

pour chacune des quatre régions. Le domaine de chaque variable

correspond à l’ensemble des couleurs. Pour chaque paire de régions

adjacentes, une contrainte binaire est créée entre les variables

correspondantes. Cette contrainte interdit toute affectation

identique de ces deux variables.

- X = {V1,V2,V3,V4}

- D = { DV1,DV2,DV3,DV4} avec DVi = {Rouge, Vert, Bleu}

- C = { V1 ≠ V2 ; V1 ≠ V4 ; V2 ≠ V3 ; V3 ≠ V4}

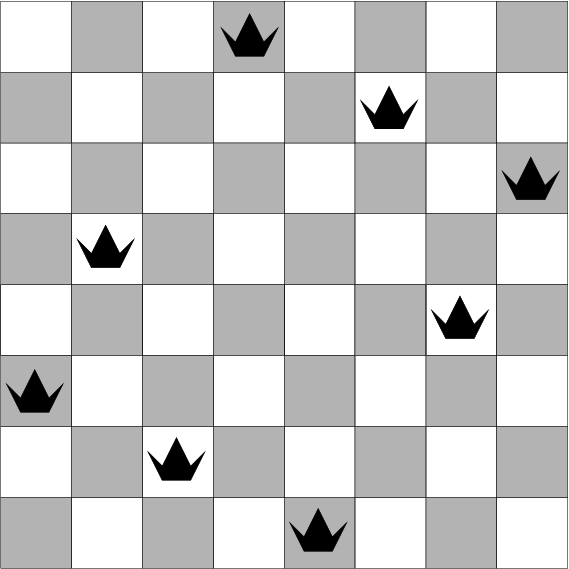

1.4.2 Le placement de reines

Le problème des n reines consiste à placer n reines sur un

échiquier n ×n de sorte qu’aucune reine ne soit en prise

avec une autre. Ceci revient à placer au plus une reine par ligne,

par colonne et par diagonale.

- X = {x1,x2, ..., xn}

- D = { Dx1,Dx2,..., Dxn } avec Dxi = {1,2,...,n}

- C est défini par, ∀i, ∀j : les reines doivent être sur des lignes différentes xi ≠ xj, les reines doivent être sur des diagonales différentes xi +i ≠ xj +j, xi - i ≠ xj - j

1.4.3 Le problème du Zèbre

Le problème du Zèbre est un puzzle logique qui figure lui aussi

parmi les classiques du

genre, il se pose comme suit : Cinq maisons de couleurs différentes sont habitées par cinq personnes de nationalités distinctes, ces personnes ont leurs boissons préférées, leurs animaux domestiques et leurs sports pratiqués eux aussi différents. Les informations dont nous disposons sont les suivantes :

- l’anglais habite la maison rouge,

- l’espagnol a un chien,

- la personne dans la maison verte boit du café,

- l’irlandais boit du thé,

- la maison verte est à droite de la maison ivoire,

- le joueur de Go possède un escargot,

- la personne dans la maison jaune joue au cricket

- la personne dans la maison du milieu boit du lait,

- le nigérien habite la première maison,

- le judoka habite à côté de la personne qui a un renard,

- le joueur de cricket est à côté de celui qui a un cheval,

- le joueur de poker boit du jus d’orange,

- le japonais joue au polo,

- le nigérien habite à côté de la maison bleue.

Le problème est modélisé en numérotant les maisons de gauche à droite, de 1 à 5. Chaque couleur, personne, chose, animal, sport, boisson constitue une variable dont le domaine contient initialement les nombres de 1 à 5. Ainsi, si la couleur bleue est instanciée par la valeur 3, cela signifie que la maison 3 est bleue. Soit la liste des variables de taille 5 suivante, rangées par catégorie :

- Anglais, Espagnol, Irlandais, Nigérien, Japonais,

- Rouge, Verte, Bleue, Ivoire, Jaune,

- Chien, Escargot, Renard, Zèbre, Cheval,

- Judo, Go, Cricket, Poker, Polo

- Lait, Guinness, Café, Thé, Jus,

- Anglais = Rouge,

- Espagnol = chien,

- Verte = Café

- Irlandais = Thé,

- Verte = Ivoire + 1

- Go = Escargot,

- Cricket = Jaune,

- Lait = 3,

- Nigérien = 1,

- | Judo - Renard | = 1,

- | Cricket - Cheval | = 1,

- Poker = Jus,

- Polo = Japonais

- | Nigérien - Bleue | = 1,

1.4.4 La règle de Golomb

Le problème de Golomb consiste à placer N marques sur une règle

pour que toutes les distances entre les marques soient

différentes, la figure 1.3 illustre le placement de

quatre marques.

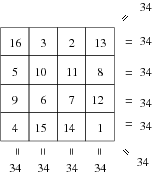

1.4.5 Les carrés magiques

Un carré magique d’ordre n est une matrice de n×n

contenant tous les nombres de 1 à n2 placés pour que chaque

ligne, chaque colonne et les deux diagonales aient la même somme.

1.4.6 SEND + MORE = MONEY

Ce puzzle de cryptarithmétique consiste à retrouver les chiffres

cachés derrière les lettres de cette addition 1.5.

| 1000 ×S + 100 ×E + 10 ×N + D | |

| + | 1000 ×M + 100 ×O + 10 ×R + E |

| = | 10000 ×M + 1000 ×O + 100 ×N + 10×E + Y |

Une formulation en CSP de ce problème peut considérer chaque lettre S, E, N, D, M, O, R, Y comme une variable. Á chaque variable, les valeurs possibles correspondent aux chiffres de 0 à 9 et l’objectif est donc de trouver la valeur de chaque variable pour satisfaire l’addition.

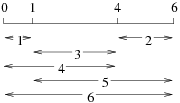

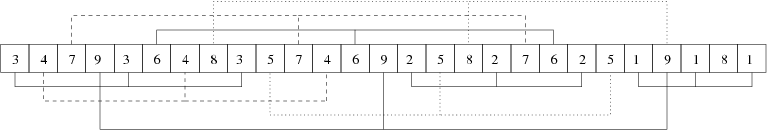

1.4.7 Le nombre de Langford

Ce problème consiste à placer deux ensembles de chiffres (de 1 à

4) dans un certain ordre de sorte que les 2 1 soient

séparés par un chiffre, les 2 2 , par 2, etc.

Le problème se généralise alors sous la forme LN(k,n), avec k

ensembles comportant chacun les nombres de 1 à n.

- | x1 - x2 | = 2

- | x3 - x4 | = 3

- | x5 - x6 | = 4

- | x7 - x8 | = 5

- x1 ≠ x2 , x1 ≠ x3, x1 ≠ x4, x1 ≠ x5 , x1 ≠ x6 , x1 ≠ x7 , x1 ≠ x8 , x2 ≠ x3 , x2 ≠ x4 , x2 ≠ x5 , x2 ≠ x6 , x2 ≠ x7 , x2 ≠ x8 , x3 ≠ x4 , x3 ≠ x5 , x3 ≠ x6 ,x3 ≠ x7 , x3 ≠ x8 , x4 ≠ x5 , x4 ≠ x6 , x4 ≠ x7 , x4 ≠ x8 , x5 ≠ x6 , x5 ≠ x7 , x5 ≠ x8 ; x6 ≠ x7 ; x6 ≠ x8 ; x7 ≠ x8

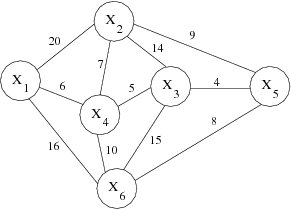

1.4.8 Le voyageur de commerce

Un exemple classique d’optimisation sous contraintes est celui du

voyageur de commerce, celui-ci doit traverser n ville,

l’objectif est donc de trouver le meilleur chemin, le plus court,

passant par ces villes (voir figure 1.8). Le

problème se modélise en CSP de manière intuitive avec n ville et

les distances entre les villes notées δxi,xj

(distance entre la ville i et et la ville j) :

- X = {x1,x2, ..., xn}

- D = { Dx1,Dx2,..., Dxn } avec Dxi = {1,2,...,n}

- C est défini par, une contrainte AllDiff(x1,...,xn) traduisant le fait que nous devons passer une seule fois par ville et par toutes les villes.

- f = min(åi=1n-1 δxi,xi+1)

1.5 Conclusion

Ce premier chapitre nous a permis d’introduire la notion de CSP et

de souligner la simplicité de ce formalisme. Nous avons vu qu’un

grand nombre de problèmes variés correpondent à des problèmes de

satisfaction de contraintes.

Au travers des exemples, nous avons énoncé différents types de contraintes. Les contraintes

arithmétiques avec des équations et inéquations mais aussi une

contrainte globale. Outre la contrainte Alldiff, qui épargne

l’écriture d’un ensemble d’inégalités, on retrouve dans cette

catégorie, à titre d’exemple, les contraintes globales de

cardinalité de type AtMost ou AtLeast.

Évidemment, un algorithme capable d’énumérer toutes les

combinaisons possibles permet de résoudre tous les problèmes

formulés en CSP, encore faut-il que le problème soit suffisamment

petit pour que le programme termine en temps raisonnable, ce qui

bien souvent n’est pas le cas. Dans les chapitres suivants, nous

allons aborder les techniques de résolution de CSP.

Chapitre 2

Résolution des CSP par

des méthodes complètes

|

2.1 Introduction

La définition donnée d’un CSP permet de représenter un grand

nombre de problèmes, comme rappelée au chapitre 1.2,

et il n’existe pas de méthode universelle pour une résolution

efficace. Diverses techniques ont été mises au point, notamment en

utilisant les notions de consistance, que nous allons développer

dans ce chapitre, ainsi que des combinaisons de ces méthodes pour

former des algorithmes de résolution.

Étant donné un CSP, un solveur a pour objectif de fournir les

solutions satisfaisant les contraintes dans la mesure où cela est

possible. Les propriétés des solveurs peuvent s’énoncer ainsi :

- Un solveur est complet s’il est toujours capable de répondre par vrai ou faux concernant l’existence d’une solution.

- Un solveur est correct s’il ne calcule que des solutions.

- Un solveur est fiable s’il calcule toutes les solutions pour un problème donné.

2.2 Generate-and-test et backtracking

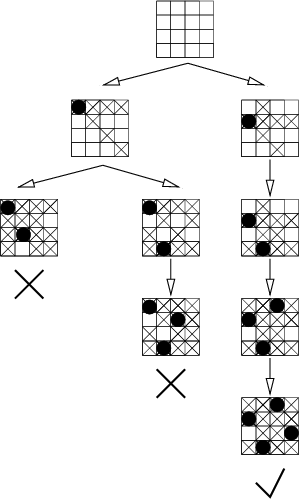

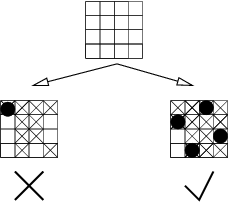

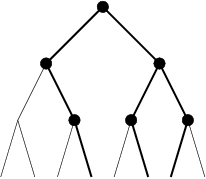

Une méthode simple pour la résolution des CSP est de générer toutes les configurations possibles, c’est à dire toutes les combinaisons possibles de valeurs des variables et de tester si elles vérifient les contraintes : auquel cas elles sont solutions. Cette approche est connue sous le nom de Generate-and-test. Le nombre de possibilités testées est alors le cardinal du produit cartésien des domaines des variables, ce qui pour les problèmes de grandes tailles devient impossible à envisager. Le backtracking est sans nul doute la méthode la plus répandue pour une recherche systématique. Pour cette méthode, les variables sont instanciées les unes après les autres et ce jusqu’à obtenir une affectation complète. Seulement, contrairement à un generate-and-test, cette méthode teste la faisabilité à chaque étape de la résolution, c’est-à-dire que pour chaque instanciation de variables, les contraintes dont les variables sont déjà instanciées sont vérifiées, sur l’affectation partielle courante . Ainsi, lorsqu’à une étape donnée, l’affectation partielle courante viole une contrainte, le backtracking supprime le sous-espace de recherche en dessous du point de choix.

2.3 Notion de consistance

Comme notre objectif est de trouver une affectation pour chaque variable satisfaisant toutes les contraintes, l’idée est alors de réduire l’espace de recherche (l’espace des possibilités). Pour ce faire, les algorithmes de résolution complets vont essayer de supprimer certaines valeurs dans les domaines, des valeurs dites inconsistantes. Une valeur est jugée inconsistante dans la mesure où elle n’est pas validé pour une ou plusieurs contraintes. Une notion de consistance est donc à associer à la notion de contrainte. En effet, une contrainte force les variables à ne prendre que certaines valeurs, la consistance intervient là où des valeurs d’un domaine ne pourront en aucun cas satisfaire cette contrainte. La propriété de consistance pour une contrainte est atteinte lorsque plus aucune valeur ne peut être supprimée. On considérera ici des propriétés de consistance locale, c’est-à-dire une consistance considérant chaque contrainte de manière indépendante. Plusieurs formes de consistances sont alors à définir en fonction des caractéristiques des contraintes, c’est pourquoi, nous verrons dans un premier temps, les contraintes ne portant que sur une seule variable, avec les consistances de noeud, puis les contraintes à deux variables avec les consistances d’arc et enfin les consistances hyper-arc et la k-consistance pour les contraintes n-aires.

2.3.1 Consistance de noeud

Commençons cet examen des consistances par la consistance de n

ud, celle-ci ne concerne que les contraintes unaires. Ce sont les

contraintes les plus simples, car elles n’affectent qu’une seule

variable.

Définition 9 [Consistance de noeud]

On dit qu’un CSP est consistant de noeud si pour chaque variable

x ∈ X, toute contrainte unaire partant sur x, coïncide avec

le domaine de x. Soit un CSP (X,D,C) et c ∈ C :

|

|

- X = { x1,...,xn}

- D = {Dx1,...,Dxn} avec ∀i ∈ [1..n] Dxi = [1..10]

- C = {x1 ≥ 2,...,xn ≥ 2}

2.3.2 Consistance d’arc

De manière informelle, une contrainte binaire est consistante

d’arc si chaque valeur de chaque domaine appartient à au moins une

paire de valeurs consistantes définie par la contrainte. On parle

alors de CSP arc consistant si toutes ses contraintes binaires

sont arc consistantes.

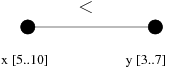

Définition 10 [Consistance d’arc]

Soit un CSP (X,D,C), soit une contrainte binaire c ∈ C portant sur les variables

x et y avec leur domaine respectif Dx et Dy, telle que

c ⊆ Dx ×Dy. Nous dirons que c est arc

consistante si :

- ∀a ∈ Dx, ∃b ∈ Dy, (a,b) ∈ c;

- ∀b ∈ Dy, ∃a ∈ Dx, (a,b) ∈ c.

|  |

2.3.3 Consistance hyper-arc

La notion de consistance hyper-arc généralise celle d’arc pour les

contraintes n-aires.

Définition 11 [Consistance hyper-arc]

Soit un CSP (X,D,C), et une contrainte c ∈ C portant sur les variables

x1, x2,...,xn avec leur domaine respectif Dx1,Dx2,...,Dxn de sorte que c ⊆ Dx1 ×Dx2 ×... ×Dxn. On dit alors que c est

hyper-arc consistante si pour chaque i ∈ [1..n] et a ∈ Dxi, il existe un n-uplet d dans c de sorte que la i-ième

composante de d soit égale à a.

Un CSP est hyper-arc consistant si toutes ses contraintes sont

hyper-arc consistantes.

Une des faiblesses des consistances présentées est qu’elles

considèrent les contraintes de manière isolée les unes des autres,

ce qui leur confère l’aspect local, alors que dans la plupart des

cas, elles partagent des variables.

2.3.4 La k-consistance

La k-consistance correspond à une généralisation des différentes

notions vues jusqu’à présent et se définit ainsi :

Définition 12 [k-consistance]

Soit s une instanciation partielle de longueur k, i.e. k

variables sont instanciées pour un CSP (X,D,C),

si s satisfait toutes les contraintes, on dit alors que

l’affectation est k-consistante.

Définition 13

Soit un CSP P, si pour toutes affectations partielles

(k-1)-consistantes, pour chacune des autres variables non

instanciées, il existe une valeur de leur domaine qui étend la

consistance en une k-consistance, alors le CSP est dit

k-consistant.

Un algorithme permettant d’établir la k-consistance a été présenté

en 1989 par [ Cooper1989]. Nous pouvons donc faire correspondre

cette notion avec les précédentes en appelant un CSP 1-consistant

s’il est consistant de noeud, 2-consistant s’il est consistant

d’arc.

2.4 Algorithmes de filtrage et propagation de contraintes

Nous avons présenté les propriétés de consistances et maintenant nous allons voir en quoi ces propriétés peuvent être utilisées pour la résolution des CSP par les méthodes complètes. Différents algorithmes sont définis pour assurer la consistance. En introduisant les notions de consistance, il va de soi de présenter les algorithmes associés. L’objectif est alors d’atteindre la propriété de consistance locale en utilisant, en outre, la propagation de contraintes et le filtrage. Atteindre la propriété de consistance locale, pour un problème donné, simplifie la résolution en réduisant l’espace de recherche. Nous nous intéressons ici à des algorithmes complets, c’est à dire capables de nous répondre si le problème est insatisfiable. Le filtrage des valeurs inconsistantes est utile pour instancier les variables et permet de retirer certaines valeurs des domaines tout en conservant les solutions. Les différents algorithmes de filtrages reposent bien sûr sur le type des contraintes exprimées. L’objectif est de réduire les domaines pour rendre les CSP consistants relativement aux propriétés de chaque contrainte. L’algorithme associé aux contraintes unaires (procédure 1) est relativement simple, il se réduit à supprimer l’ensemble des valeurs ne satisfaisant pas la contrainte. [!hbt]

#1Consistance de n ud() Pour atteindre la consistance d’arc, il est nécessaire de vérifier les couples de valeurs possibles. La procédure Révise_arc, extraite de [ Mackworth1977], permet d’atteindre pour un arc donné, la propriété de consistance. [!hbt] #1Révise_arc(Vi,Vj) Soit Supp un Booleen

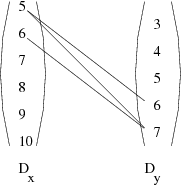

Supp ← Faux

En ce qui concerne les contraintes binaires, pour faire en sorte que chaque arc soit consistant, une seule application de la procédure révise est insuffisante. En effet, la suppression d’une valeur d’un domaine pour une contrainte donnée peut avoir des répercussions sur les autres contraintes sur ce domaine. Exemple : Révise_arc Pour l’exemple 2.2 considérons une deuxième contrainte. Rappelons que le CSP est défini par deux variables x, y avec Dx = [5..10] et Dy = [3..7]. Les contraintes sont c1 : x > y et nous ajoutons c2 : x+ y = 11. Le résultat de l’application des procédures Révise_arc est présenté par la figure 2.3. Nous remarquons dans cet exemple que la suppression de valeurs par c1 en c. entraîne une autre application de la procédure pour c2 en d. pour l’arc y,x bien qu’il soit déjà étudié en b.

Q ← {(Vi,Vj) ∈ arcs(G), i ≠ j};

Soit CHANGE un Booleen

[!hbt] #1AC-3() Soit Q l’ensemble des arcs du graphe des contraintes G;

Q ← {(Vi,Vj) ∈ arcs(G), i ≠ j};

Soit CHANGE un Booleen

2.4.1 Les contraintes globales

Le filtrage des valeurs par arc-consistance est souvent insuffisant car il ne tient pas compte des liens existant entre les contraintes. Pour être plus efficace, des contraintes globales ont été introduites, celles-ci parfois correspondent à es conjonctions de plusieurs contraintes. Un algorithme de filtrage est alors dédié à la contrainte pour un meilleur filtrage. La première et la plus célèbre est la contrainte globale de type Alldiff (conjonction de contraintes de différence), une procédure permet de filtrer les domaines à condition qu’au moins un domaine se résume à une seule valeur. Exemple : CSP avec contrainte Alldiff

Considérons le CSP (X,D,C) où:

- X = { x1, x2, ,x3}

- D = {Dx1,Dx2,Dx3} avec Dx1 = {1}, Dx2 = {1;2} et Dx3 = {2;3}

- C = { AllDiff(x1,x2,x3)}

Les avantages apportés par une modélisation avec des contraintes globales ne se limitent pas à des procédures de filtrage spécifiques. On retrouve également des procédures de vérification capables de prouver l’inconsistance d’un problème (voir exemple 4). Exemple Vérification pour AllDiff

Considérons le CSP (X,D,C) avec :

- X = { x, y , z}

- D = {Dx,Dy,Dy} avec Dx = Dy = Dx = {1;2}

- C = { x ≠ y , x ≠ z , y ≠ z }

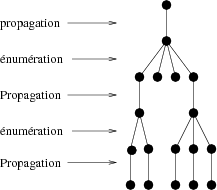

2.5 Méthodes de recherche et algorithmes de résolution

Après avoir présenté le backtrack, le filtrage et la

propagation de contraintes, nous sommes en mesure de définir des

algorithmes complets pour la résolution de CSP.

Dans un premier schéma, la résolution se résumait à instancier les

variables les unes après les autres tout en testant si elles ne

violent pas de contraintes. Nous pouvons à présent utiliser les

consistances et propager pour réduire l’espace vers un problème

plus simple à résoudre à chaque n ud et ainsi limiter les

points de choix. En général, un algorithme de backtrack standard

en profondeur d’abord est appliqué avec, à chaque n ud de

l’arbre de recherche, une propagation de contrainte à des niveaux

plus ou moins élevés selon les méthodes (voir figure

2.4) et comme aucune solution n’est perdue

pendant la recherche, la résolution reste complète. Le backtrack a

pour but une énumération des valeurs des variables (voir chapitre

2.2) avec à chaque étape un choix a effectuer sur la

variable qui sera énumérée ainsi que sur les valeurs choisies.

2.6 Conclusion

Nous avons vu que les propriétés des contraintes sont utiles pour

réduire l’espace de recherche, et que le backtrack et les

propriétés de consistance locale permettent une résolution

complète d’un problème.

Par une propagation des contraintes (à des degrés différents) et différentes

stratégies de parcours de l’arbre de recherche (le plus commun

étant en profondeur d’abord), un simple backtracking se transforme

alors en un solveur parfois assez complexe. Seulement ce mode de

résolution semble atteindre ses limites pour certains problèmes où

les contraintes ne permettent pas de réduire un espace de

recherche de manière significative et où un parcours complet de

l’arbre des possibilités, malgré le filtrage, semble dès lors

impossible. C’est dans ce contexte que les méthodes dites

incomplètes ont émergé et feront l’objet du chapitre suivant.

Chapitre 3

Résolution des CSP par

des méthodes incomplètes

| Les méthodes incomplètes (telles que la recherche locale (LS) [ Aarts and Lenstra1997]) reposent sur des heuristiques permettant d’étudier des zones spécifiques de l’espace de recherche dans le but d’atteindre une solution. Ce chapitre propose un panorama non exhaustif de ces méthodes. |

3.1 Introduction

L’utilisation de métaheuristiques est apparue comme une issue face

à des problèmes combinatoires dont les espaces de recherche

explosent en taille. Pour les problèmes NP-difficiles, en

admettant que P ≠ NP, il n’existe pas d’algorithme en temps

polynomial et donc une résolution complète entraîne un temps de

calcul exponentiel dans le pire des cas. Le développement récent

de ces méthodes témoigne d’une part de l’intérêt que nombre de

chercheurs y portent, mais aussi du potentiel de ces paradigmes de

résolution. Les métaheuristiques sont basées sur deux concepts

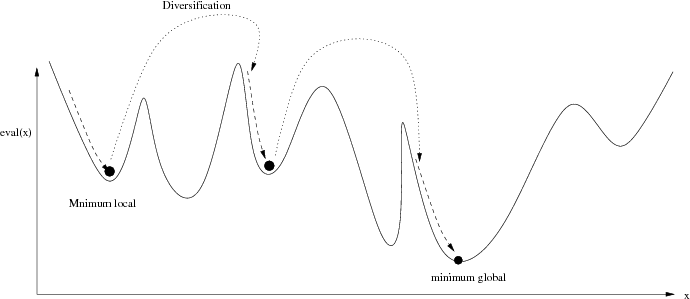

majeurs :

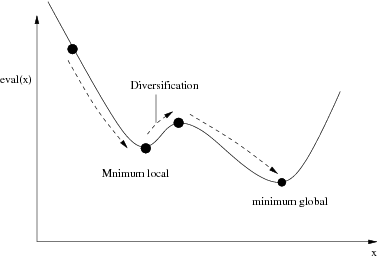

- l’intensification consiste à fouiller une zone réduite de l’espace de recherche pour en extraire éventuellement une solution,

- et la diversification qui permet à la recherche de se déplacer dans l’espace plus largement.

3.2 La recherche locale

Nombre de méthodes sont apparues combinant différentes

heuristiques, ces combinaisons sont appelées métaheuristiques

(dérivé du verbe grec heuriskein εuriskεin signifiant

rechercher et du suffixe méta pour au niveau

supérieur, au-delà de ). Ces méthodes considèrent l’espace de

recherche dans sa totalité, l’ensemble des affectations possibles

des variables. L’idée est donc, de ne pas visiter toutes ces

configurations, mais de se doter d’heuristiques pour choisir les

zones d’exploration. Les méthodes présentées correspondent à des

schémas généraux qui leur confèrent le statut de métaheuristiques.

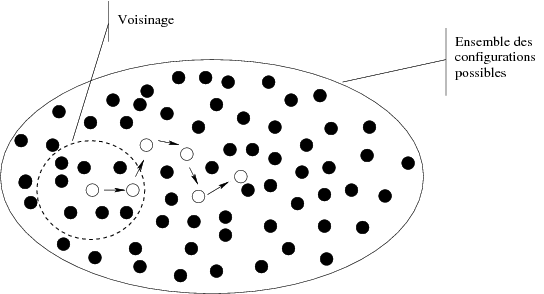

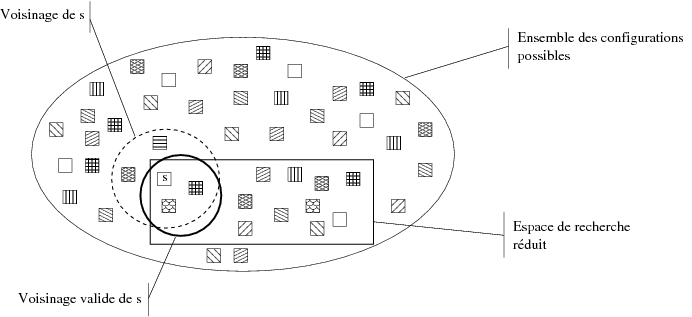

3.2.1 Recherche par voisinage

Le principe de base d’une recherche locale est de partir d’une

configuration initiale (d’une affectation complète) et par un

processus itératif, de remplacer la configuration courante par une

meilleure prise dans ce qui est défini comme son voisinage. L’idée

est donc d’être capable, si on améliore une configuration

progressivement, d’atteindre une solution. En se déplaçant de

proche en proche (s0 → s1 → ...) dans l’espace de

recherche, la configuration courante est progressivement corrigée

de ses défauts (dans notre contexte il s’agit de contraintes non

satisfaites). Le voisinage représente des affectations autour de

la configuration courante, accessibles en modifiant certains

attributs (valeurs des variables) et est très souvent relatif au

problème posé. Le voisinage se définit généralement comme suit :

Définition 14 [Voisinage]

Soit S un espace de recherche (appelé aussi espace des

configurations), un voisinage est une fonction :

|

|

Soit x une configuration initiale prise aléatoirement

Le processus de descente simple se limite à une zone de recherche et ne permet pas de sortir des optimums locaux (figure 3.2).

Soit x’ une configuration initiale et

x la meilleure solution trouvée avec eval(x) ← ∞

3.2.2 Algorithmes de recherche locale

Les algorithmes présentés sont à considérer comme des stratégies

guidant la recherche basées sur le principe de voisinage,

d’évaluation et de l’alternance des deux phases, à savoir

intensification et diversification.

Le Recuit Simulé Simulated Annealing

Le recuit simulé est considéré comme la première métaheuristique pourvue d’une stratégie pour échapper aux minimums locaux. Son origine se trouve dans la description des phénomènes physiques en métallurgie. C’est dans [ Kirkpatrick et al. 1983] que ce processus est exploité pour la première fois pour la résolution des problèmes d’optimisation. Le principe de cette méthode est d’autoriser les déplacements vers des configurations de qualité moindre (que la courante) sous certaines probabilités. L’algorithme 3.3, dans ses grandes lignes, commence par s’initialiser avec une configuration complète et un paramètre température T. Pendant la recherche, la température T décroît selon une fonction de refroidissement qui influe sur les conditions d’acceptation d’une configuration en fonction de la dégradation qu’elle induit. Au début de la recherche, les configurations plus mauvaises sont acceptées facilement, en revanche au fur et à mesure que la recherche avance, la température T décroît ce qui réduit les chances d’acceptation pour une affectation de qualité moindre et permet d’assurer entre autre une certaine convergence de l’algorithme. #1Recuit SimuléSoit x une configuration initiale

Soit T une fonction de refroidissement et T une température initiale

Recherche Tabou

L’idée de base d’une recherche tabou a été introduite par [ Glover1986] sur des intuitions déjà présentes dans [ Glover1977]. Cette méthode est sans doute la plus populaire des métaheuristiques. Elle se base sur une descente avec sélection du meilleur voisin et sur une mémoire à court terme des précédentes configurations rencontrées, pour éviter les cycles (algorithme 3.4). Une liste est alors maintenue pour conserver la trace des affectations visitées et en interdire un nouveau passage. L’unique paramètre est la longueur l de cette liste. #1Recherche tabouSoit x une configuration initiale

Soit l une liste tabou dont la taille maximale est k

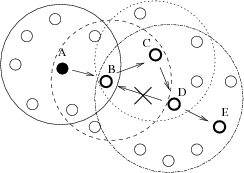

Dans la figure 3.4 la recherche débute en un point A de l’espace de recherche, quand la configuration D est atteinte, le mouvement de retour sur B est interdit ce qui contraint la recherche tabou à se diriger vers E en second choix.

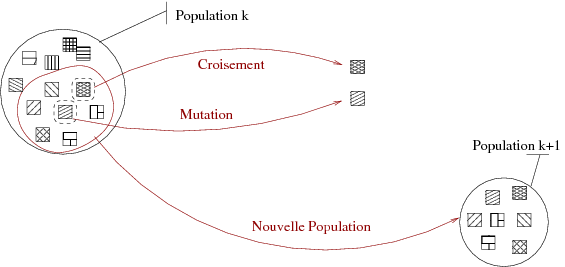

3.3 Les algorithmes génétiques

Basés sur le principe de la sélection naturelle, les

algorithmes génétiques [ Goldberg1989a, Holland1975a] ont été appliqués

avec succès aux problèmes combinatoires tels que les problèmes

d’ordonnancements ou de transports.

Le principe fondamental de cette approche est basé sur le fait que

les espèces évoluent par adaptations à un environnement changeant

et que le savoir acquis est inclus dans la structure de la

population et de ses membres, codé dans leurs chromosomes. Les

algorithmes évolutionnaires sont donc principalement basés sur la

notion d’adaptation des individus d’une population, cette

population évolue comme dans la théorie darwinienne, par des

générations successives. Chaque nouvelle génération est

généralement créée à partir de la précédente grâce à des

opérateurs d’évolution comme le croisement de deux individus ou la

mutation sur un gène d’un individu. Si des individus sont

considérés en tant que solutions potentielles d’un problème donné

(généralement un individu correspond à une affectation),

l’application d’un algorithme génétique consiste en la génération

successive de meilleurs individus. L’objectif est d’améliorer la

qualité des individus, mesurée par une fonction d’évaluation, en

faisant du croisement, une concaténation des meilleurs gènes des

parents et de la mutation une amélioration de l’individu. Nous

renvoyons le lecteur à [ Michalewicz1996] pour plus de détails.

Les populations

Un algorithme génétique comprend comme composant de base une population, c’est-à-dire un ensemble d’individus correspondant à une représentation des solutions potentielles. Dans la plupart des cas, un individu est un chromosome défini par ses gènes. Dans notre cas, un individu est une affectation de valeurs aux variables. Il est donc nécessaire que l’algorithme se dote d’un mécanisme de création d’une population initiale.L’évaluation

Un autre élément à définir lorsque l’on conçoit ce type d’algorithme est la fonction d’évaluation. Cette fonction, que nous notons eval, évalue chaque solution potentielle selon le problème donné. Dans le cas des CSP cette fonction évalue le nombre de contraintes violées.Les opérateurs génétiques

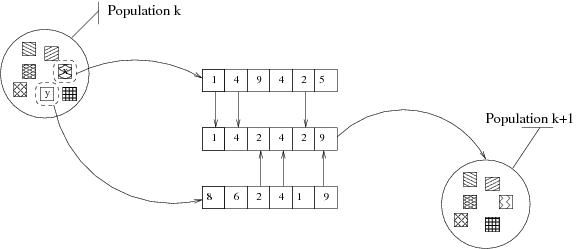

Les opérateurs génétiques définissent la génération des enfants pour la création de la population suivante. Deux opérateurs différents :- le croisement produit de nouveaux individus (les

descendants) en croisant des individus de la population courante

(les parents). Un exemple de croisement est donné en figure

3.5, il représente un croisement uniforme qui, à

partir de deux parents x et y, créé un nouvel individu

résultat de la recombinaison des gènes et qui sera ensuite inséré

dans la population.

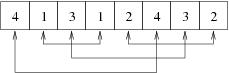

Figure 3.5: Exemple de croisement uniforme

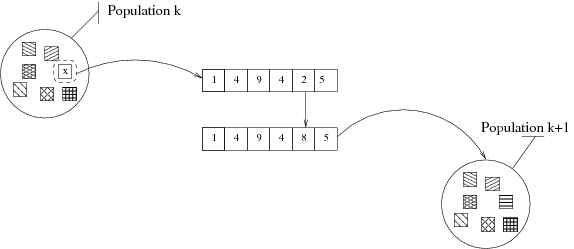

- la mutation, change arbitrairement un ou plusieurs

gènes d’un individu choisi. La figure 3.6 nous montre

comment, depuis un individu sélectionné dans une population k,

un gène est muté dans k+1. Les mutations sont généralement

utiles pour apporter de nouvelles informations. On peut très bien

imaginer que, dans notre exemple, la valeur 8 n’apparaît dans

aucun individu de la population k. La mutation dans ce cas

introduit cette valeur et donc, ouvre la possibilité à de

nouvelles configurations.

Figure 3.6: Exemple de mutation sur un gène

La sélection

Un dernier principe de base à définir est la sélection d’individus. L’objectif est de ne conserver que les meilleurs individus afin d’assurer une convergence globale. Nous pouvons retrouver ici le principe d’élitisme qui consiste à sélectionner la ou les meilleures configurations. Toutefois, cette opération de sélection se doit de préserver une certaine diversité dans la population, on y retrouve alors la mesure d’entropie pour une meilleure répartition des individus dans l’espace de recherche. Que ce soit pour la mutation ou pour le croisement, une sélection doit avoir lieu, dans la figure 3.7 des individus sont sélectionnés pour être soumis aux opérateurs de croisement ou mutation. De même, un ensemble d’individus est choisi pour constituer une nouvelle génération.

3.4 Conclusion

Nous avons présenté les algorithmes pour les méthodes de

recherches locales ainsi que le principe général qui régit un

algorithme à base de population. Toutes ces méthodes s’appliquent

à un grand nombre de problèmes différents et une métaheuristique

constitue en quelque sorte un cadre qui s’adapte au problème posé.

L’univers des méthodes incomplètes est vaste, beaucoup de méthodes

ne sont pas présentées ici (Variable Neighborhood

search[ Mladenovi\’c and Hansen1997], GRASP [ Feo and Resende1995], Idwalk

[ Neveu et al. 2004]...). Elles donnent pour la plupart des clefs

permettant de sortir des optimums locaux et ont prouvé leur

efficacité sur des problèmes allant de la gestion de ressources

réseaux aux problèmes d’affectation, en passant par la

bioinformatique.

Bien qu’il s’agisse dans la plupart des cas de problèmes à base de

contraintes, une structuration différente du problème est utilisée

par les méthodes incomplètes vis à vis des méthodes complètes.

Dans les premières (incomplètes), l’ensemble des affectations

complètes est considéré tandis que dans l’autre, des affectations

partielles sont construites incrémentalement. Cependant nous

verrons par la suite, au travers d’exemples, qu’une hybridation

peut s’avérer très efficace.

Chapitre 4

Résolution hybride

| L’hybridation de méthodes complètes et incomplètes vise à profiter de leurs atouts respectifs en les fusionnant. La combinaison se fait soit au travers d’une collaboration de ces méthodes, soit par une intégration plus fine. Dans ce chapitre, nous dresserons un panorama des niveaux d’intégration et de collaboration pour des méthodes d’origines et de structures intrinsèquement différentes. |

4.1 Introduction

Comme nous l’avons vu au chapitre 2, les méthodes complètes apportent des garanties en ce qui concerne l’obtention d’une

solution optimale à un problème donné. L’inconvénient est que le temps de calcul augmente de

façon exponentielle avec la taille des instances. Dans ce

contexte, la garantie de l’optimalité est alors concédée vis-à-vis

du temps de calcul.

Pour pallier ce sacrifice, une idée largement répandue pour la

conception de solveurs plus efficaces et robustes, consiste à

combiner plusieurs paradigmes de résolution, afin de bénéficier

des atouts respectifs de chacun d’entre eux. ([ Focacci et al. 2002]

dresse un panorama de telles utilisations de recherche locale (LS)

dans la programmation par contrainte (CP)). Nous retrouvons alors

des hybridations dans lesquelles la recherche locale est utilisée

avec des mécanismes complets pour rendre les voisinages étendus

plus intéressants [ Shaw1998]. Une autre méthode phare

s’appuie sur la recherche locale afin de réparer des affectations

partielles et utilise les techniques de filtrage [ Jussien and Lhomme2002].

Les bénéfices des

combinaisons LS+CP sont bien connus, et

[ Prestwich2000, Pesant and Gendreau1996] proposent des

hybridations entre des méthodes de recherche locale et des

techniques de propagation de contraintes.

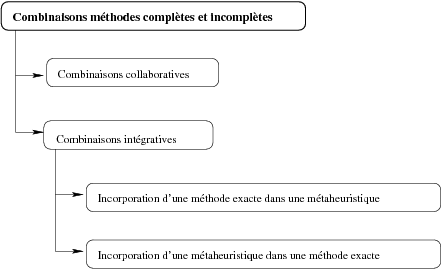

- la collaboration : on combine une méthode exacte et une métaheuristique exécutée en prétraitement et vice-versa. Les méthodes peuvent également fonctionner en parallèle tout en échangeant des informations.

- l’intégration : une LS aide un algorithme complet : à quelques n uds de l’arbre de recherche, construits par l’algorithme de backtracking, la LS est utilisée pour tenter d’atteindre une solution, en partant d’une affectation partielle ou pour améliorer une configuration complète. La LS peut être ainsi considérée comme un mécanisme de réparation supplémentaire. Dans d’autres cas, la LS guide entièrement la recherche : la propagation de contraintes peut être utilisée pour limiter le voisinage ou élaguer des branches de l’espace de recherche. Des techniques complètes sont également utilisées pour explorer le voisinage de la configuration actuelle et choisir la prochaine étape du processus de LS.

4.2 Approches Collaboratives

Dans ce type de combinaison, les algorithmes proposés correspondent à une association de haut niveau entre

métaheuristiques et méthodes complètes, (i.e. aucun algorithme

n’est inclus dans un autre). Ainsi, la combinaison la plus répandue

est l’utilisation en séquence.

La méthode exacte est soit exécutée comme un prétraitement, ou soit

elle utilise la métaheuristique.

Dans [ Applegate et al. 1998] une méthode est proposée pour l’obtention de solutions quasi

optimales du problème du voyageur de commerce. Un ensemble des

solutions est extrait via des exécutions d’une recherche locale

itérative. Les ensembles d’arêtes sont réunis et le problème se

réduit au calcul de l’optimum sur un graphe largement simplifié.

De cette façon, la solution obtenue est habituellement meilleure

que la meilleure des solutions de la recherche locale.

Beaucoup de problèmes d’optimisation possèdent une certaine

structure, c’est-à-dire les configurations de bonnes qualités ont

un grand nombre de caractéristiques communes avec les solutions

optimales. Cette observation peut être exploitée de plusieurs

manières en définissant des sous-problèmes appropriés vis-à-vis du

problème original. Dans la plupart des cas, les sous-problèmes

résultants sont suffisamment petits pour être résolus par une

méthode exacte.

Ce type d’approche se décompose en deux phases. Dans une première,

un algorithme approximatif est utilisé pour collecter des

solutions du problème considéré. Basé sur la composition des

solutions, un sous problème est défini. Il est alors nécessaire

que le sous problème généré contienne si ce n’est toutes, au moins

la plupart des variables de décisions importantes , et

qu’il se résolve facilement.

Les grandes lignes pour cette méthode sont présentées par 4.1.

[!hbt]

#1Exploiter la structure par collecte d’informations

Parfois, une version relaxée du problème original est résolue de façon optimale et les solutions obtenues sont réparées pour constituer les points de départ d’une métaheuristique. La relaxation en programmation linéaire (PL) est souvent utilisée dans ce but. Par exemple, [ Feltl and Raidl2004] résolvent le problème d’affectation généralisé, avec un algorithme génétique hybride : la relaxation PL du problème est traitée par CPLEX et ses solutions fournissent une population d’individus qui seront, si besoin est, soumis à des opérateurs de réparation pour constituer la population initiale. Une autre approche de type séquentiel est celle d’un B&B couplé à un AG décrit dans [ Nagar et al. 1995] où les solutions du problème d’ordonnancement flow-shop (ou atelier en ligne) avec deux machines sont représentées en tant que permutation des tâches. Avant l’application de l’AG, un B&B est utilisé jusqu’à une certaine profondeur k et les bornes calculées sont enregistrées à chaque n ud de l’arbre B&B. Pendant l’exécution de l’algorithme génétique, les solutions partielles jusqu’à une certaine position k, sont mises en correspondance sur leur n ud associé de l’arbre. Si les bornes indiquent qu’aucun chemin qui suit le n ud, ne mène à une solution, la configuration subit alors une mutation.

4.3 Approche intégrative

Cette fois, la combinaison est plus fine, dans une approche

intégrative les méthodes sont plus étroitement liées.

4.3.1 La recherche locale au secours de l’algorithme complet

L’efficacité d’une méthode complète réside aussi bien dans le choix de la variable à instancier et de la valeur de cette instanciation que dans les outils

dont elle se dote pour établir la consistance.

Métaheuristique pour l’obtention de bornes

Des heuristiques permettent d’établir un ordre sur les variables à instancier afin de réduire l’arbre de recherche et de retarder le backtrack. Elles indiquent l’ordre des valeurs le plus approprié pour trouver une solution plus rapidement ou anticipent le fait que l’affectation partielle courante ne permette pas d’atteindre une solution. Dans le formalisme CSP, avec des contraintes impératives, l’objectif est de trouver une affectation des variables ne violant aucune contrainte. Dans ce contexte, les méthodes incomplètes sont très efficaces, pas trouver une solution directement, ou pour minimiser le nombre de contraintes violées et fournissent alors une borne supérieure suffisamment précise pour un algorithme de type branch and bound. Par exemple, [ Woodruff1999] présente une stratégie de sélection chunking based pour décider des n uds dans l’arbre de B&B où sera appelée la procédure tabou réactive, laquelle pourra trouver une solution. Cette stratégie mesure la distance entre le n ud courant et les n uds déjà explorés par une métaheuristique pour influer sur la sélection. Les expérimentations montrent que l’ajout de métaheuristiques améliore les performances du B&B.Affaiblissement des méthodes complètes

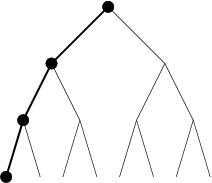

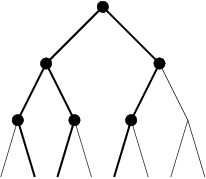

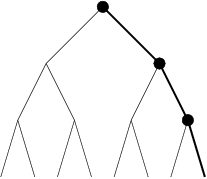

La notion d’affaiblissement intervient dès lors qu’une méthode perd sa complétude. Les raisons, qui contraignent l’exploration à élaguer certaines branches de l’arbre de recherche, peuvent être liées à un temps d’exécution limité ou la décision de concentrer la recherche sur une zone jugée plus intéressante et prometteuse. C’est justement, dans ce type de décision qu’interviennent des heuristiques, et de façon plus globale, les méthodes incomplètes. Certaines méthodes consistent, sur la base d’une heuristique, à supprimer certains n uds. Par exemple, [ Ginsberg and Harvey1990] présente un algorithme appelé iterative broadening. Dans cet algorithme un chemin est initialement proposé par une heuristique. Les domaines des variables sont ainsi réduits à une seule valeur. Puis de manière incrémentale, à chaque fin d’exploration d’un problème simplifié, on réalise une réduction moins forte des valeurs des domaines, en prenant en compte les i premières valeurs des domaines. Limited Discrepancy search (LDS) [ Harvey and Ginsberg1995] est un algorithme de recherche qui limite l’effort de recherche dans des régions de l’arbre jugées plus prometteuses pour trouver une solution. |  |

| discrepancy 0 | discrepancy 1 |

|  |

| discrepancy 2 | discrepancy 3 |

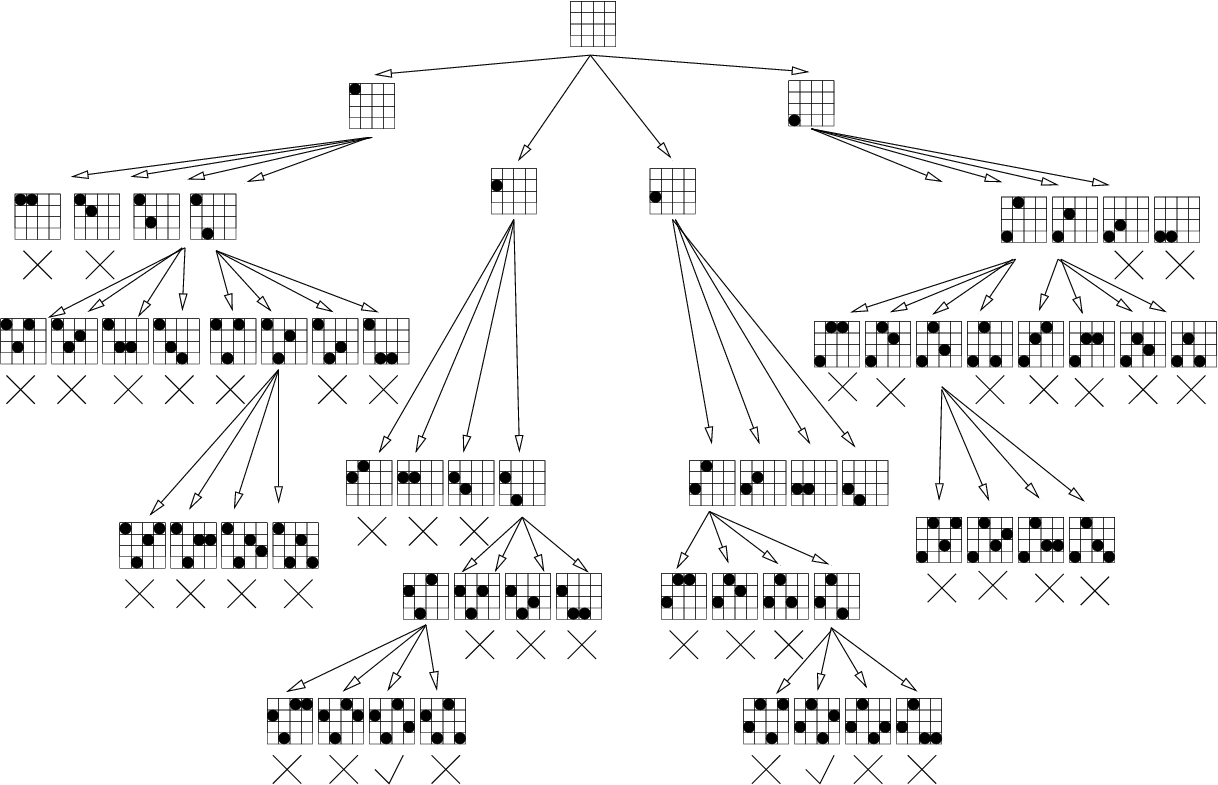

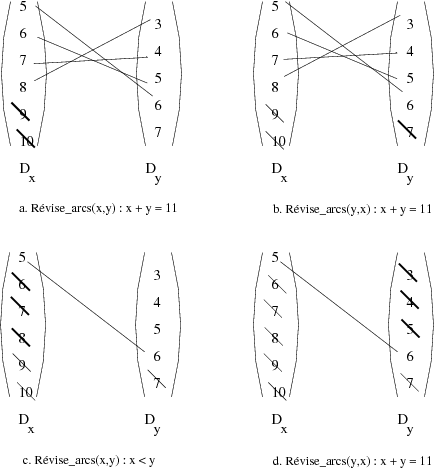

Le processus de recherche choisit dans un premier temps, les meilleurs n uds en fonction d’heuristiques données à chaque point de décision (ce que l’on nomme la recherche discrepancy 0). Si aucune solution n’a pu être trouvée, avec une discrepancy 0, le processus de recherche permet de sélectionner un autre sous-n ud à chaque point de décision (discrepancy 1). Si une solution ne peut être atteinte, la recherche se fait ensuite par augmentation des n uds visités de façon incrémentale (discrepancy 2, discrepancy 3). La figure 4.2 nous montre les chemins parcourus par une recherche LDS sur un arbre binaire de profondeur 3. Supposons que l’heuristique mise en uvre ordonne les n uds de gauche à droite, avec une (discrepancy 0) la recherche sélectionne le n ud gauche à chaque point de décision. L’ensemble des chemins possibles est alors emprunté à la (discrepancy 3).

4.3.2 Une méthode complète au c ur du voisinage d’une

recherche locale

Nous considérons ici les techniques dans lesquelles des algorithmes

exacts sont incorporés dans des métaheuristiques.

Recherche exacte et voisinage large

Une idée assez répandue consiste à explorer les voisinages, dans une métaheuristique à base de recherche locale, au moyen d’algorithmes exacts. Si le voisinage est choisi de façon appropriée, il peut être de grande taille. Néanmoins, une recherche efficace saura trouver le meilleur voisin. Ces techniques sont connues sous le nom de Very Large-Scale Neighborhood (VLSN) search [ Ahuja et al. 2002]. L’idée centrale, dans ce type d’algorithme combinant recherche locale et méthodes exactes, est de modéliser le problème d’une recherche dans un grand voisinage comme un problème d’optimisation, lequel est résolu par une méthode exacte. La solution obtenue remplace alors la solution courante de la recherche locale. Un algorithme général d’une telle méthode peut se décrire par l’algorithme 4.2 [!hbt] #1Recherche dans un voisinageUne autre possibilité est que seule une partie du voisinage soit examinée à chaque étape de recherche locale. Ce qui se fait classiquement lorsqu’une partie de la solution courante est conservée, définie comme solution partielle, et que les autres variables de décision sont laissées libres. L’algorithme 4.3 présente une vue d’ensemble d’une telle procédure. [!hbt] #1Recherche partielle dans un voisinage

[ Burke et al. 2001] présente une recherche locale avec voisinage variable pour le problème du voyageur de commerce, dans laquelle les auteurs insèrent un algorithme exact dans la partie recherche locale, appelée HyperOpt, dans le but de rechercher de manière exhaustive de larges, mais prometteuses régions de l’espace des solutions. De plus, ils proposent une hybridation HyperOpt et 3-opt permettant de bénéficier des avantages des deux approches, utilisant cette hybridation à l’intérieur d’une recherche à voisinage variable. Ils sont capables alors d’outrepasser les optima locaux et ainsi de créer des parcours de qualité. Dynasearch [ Congram2000] est un autre exemple où des voisinages de grande taille sont explorés. Le voisinage où la recherche est exécutée se compose de toutes les combinaisons possibles, des étapes mutuellement indépendantes, d’une recherche simple . Un mouvement de Dynasearch se compose d’un ensemble de mouvements indépendants exécutés en parallèle par itération de recherche locale. L’indépendance pour Dynasearch signifie que les différents mouvements n’interfèrent pas entre eux ; dans ce cas, la programmation dynamique peut être employée pour trouver la meilleure combinaison de mouvements indépendants. Dynasearch est limité aux problèmes où les étapes de recherche sont indépendantes, et n’a été jusqu’ici uniquement appliqué qu’aux problèmes où les solutions sont représentées par des permutations. [ Puchinger et al. 2004] propose une combinaison AG/B&B pour résoudre le glass cutting problem où l’AG utilise une représentation sous forme de permutation : order-based laquelle est décodée par une heuristique gloutonne. L’algorithme de B&B est appliqué avec une certaine probabilité améliorant la phase de décodage en générant des sous-motifs optimaux. N. Jussien et O. Lhomme [ Jussien and Lhomme2002] proposent un algorithme hybridant recherche locale et méthodes complètes. L’idée centrale de decision repair est basée sur des contraintes d’énumération, une affectation partielle est alors crée par ces contraintes, des contraintes d’énumération sont ensuite ajoutées. La recherche locale se réalise dans ce contexte sur un chemin de décision aidée par des techniques de filtrage. De plus une liste taboue des décisions est maintenue pour mémoriser les échecs rencontrés et guider la recherche.

Recouper les solutions

Les sous-espaces définis par le recoupement d’attributs depuis deux solutions ou plus, peuvent, comme le voisinage d’une seule solution, être aussi explorés par une méthode exacte. Les algorithmes de [ Applegate et al. 1998, Klau et al. 2004] suivent cette idée, mais de manière séquentielle. Dans cette partie, nous nous focalisons sur un recoupement appliqué itérativement au travers d’une métaheuristique. Dans le cadre [ Cotta and Troya2003] pour l’hybridation B&B et des algorithmes évolutionnaires, le B&B est utilisé en tant qu’opérateur d’un algorithme évolutionnaire. Les auteurs rappellent les concepts théoriques et notamment le potentiel dynastique de deux chromosomes x et y, correspondant à l’ensemble des individus porteurs d’information sur x et y. Basée sur ce concept, ils développent l’idée d’une recombinaison dynastique optimale. Le résultat est un opérateur explorant le potentiel des solutions recombinées grâce au B&B, fournissant ainsi les meilleures combinaisons à partir des parents. L’ensemble des expérimentations, comparant différents opérateurs de croisement avec cette méthode hybride, montre l’utilité d’une telle approche. [ Marino et al. 1999] présente une approche où un AG est combiné à une méthode exacte pour le Linear Assignment Problem (LAP) afin de résoudre le problème de coloriage de graphes. L’algorithme LAP est incorporé dans l’opérateur de croisement et génère la permutation de couleurs optimale. Cet algorithme n’est pas plus performant que les autres approches, mais fournit des résultats comparables.Filtrer l’espace de recherche

Si les métaheuristiques utilisent les contraintes pour une fonction d’évaluation, elles peuvent utiliser la formulation de ces contraintes et exploiter le fait qu’elles puissent réduire l’espace de recherche, notamment grâce aux algorithmes établissant la consistance. Dans [ Vasquez and Dupont2002], les contraintes binaires permettent un filtrage par arc consistance réduisant l’espace à explorer pour la méthode Tabou.Utiliser le schéma d’une méthode incomplète pour une méthode complète

H. Deleau propose dans sa thèse [ Deleau2005] un cadre d’hybridation dans lequel la structure des algorithmes génétiques est utilisée pour modéliser un recherche complète. Le principe général des algorithmes génétiques est alors conservé, mais l’originalité vient du fait que cette fois les individus correspondent à des sous-ensembles de l’espace de recherche. Ce cadre unificateur intègre alors des mécanismes de réduction propres aux méthodes complètes sur ces individus pour réduire l’espace de recherche.

4.4 Conclusion

De telles combinaisons ont été aussi étudiées afin d’améliorer

l’efficacité des méthodes évolutionnistes pour des CSP

[ Tam and Stuckey1999, Riff Rojas1996]. Ces algorithmes hybrides sont

appliqués aux divers problèmes de satisfaction de contraintes

(satisfiabilité en logique propositionnelle [ Lardeux et al. 2005],

le problème du voyageur de commerce...).

La principale conclusion que nous pouvons tirer est qu’il existe

beaucoup d’opportunités pour développer de tels algorithmes

hybridant méthodes exactes et techniques de recherche locale. Un

certain nombre d’approches a été présenté, parfois complexes,

pouvant être améliorées et étendues vers des applications

différentes de celles proposées initialement.

Ces techniques partagent néanmoins une philosophie commune sur la combinaison de méthodes

complètes et incomplètes. Une méthode est

désignée comme le processus de recherche principal et une autre

secondaire est utilisée comme heuristique d’amélioration avec une

organisation hiérarchique est presque figée. Pour chaque méthode

de résolution, une structure spécifique est décrite, ce qui limite

les possibilités de se comparer aux autres méthodes.

Il est nécessaire dès lors, d’homogénéiser les définitions et les

concepts mis en jeux pour la combinaison des méthodes complètes et

incomplètes. Pour atteindre cette généralisation, la difficulté

réside dans la recherche d’un cadre général unificateur.

Chapitre 5

Cadre et algorithme

générique pour la propagation

de contrainte

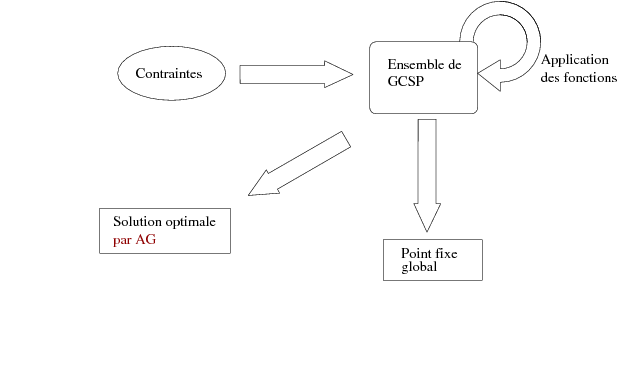

| Krzysztof Apt présente dans [ Apt1997, Apt1999] un cadre théorique pour modéliser les opérations élémentaires effectuées par un solveur complet. Dans ce contexte, la propagation de contrainte et le filtrage correspondent au calcul du point fixe d’un ensemble de fonctions sur un ordre partiel. Ces fonctions, appelées fonctions de réduction, abstraient la notion de contraintes. Dans ce chapitre nous rappellerons le cadre et l’Algorithme Générique qui nous permet d’atteindre ce point fixe. Nous nous placerons dans le contexte des domaines composés pour approcher au mieux le modèle CSP. |

5.1 Introduction

Comme le montrent les chapitres qui précèdent, il existe une

grande variété de méthodes pour résoudre les problèmes de

satisfaction de contraintes. Certaines utilisent la propagation de

contraintes pour réduire les domaines et donc diminuer l’espace de

recherche jusqu’à réduire éventuellement les domaines à de simples

singletons. Dans ce chapitre nous allons présenter un cadre pour

modéliser la propagation de contraintes, ses propriétés, et un

algorithme générique issu de [ Apt2003]. Ce cadre nous sera

très utile par la suite. En effet, il permet d’abstraire le

fonctionnement des algorithmes pour la résolution des CSP. Cette

abstraction consiste en une formulation mathématique des

opérations de résolution et de leurs propriétés.

L’objectif est alors de montrer que la propagation de contraintes

peut être expliquée en terme d’itérations chaotiques menant à un

point fixe d’un ensemble fini de fonctions. Le calcul des limites

d’ensembles de fonctions doit son origine à l’analyse numérique

avec [ Chazan and Miranker1969], et fut adapté pour l’informatique avec

[ Cousot1978, Cousot and Cousot1977]. Quant à l’idée de concevoir

l’utilisation des contraintes en terme de fonctions, elle fut

développée notamment par [ Benhamou1996] avec les fonctions de

narrowing attachées aux contraintes, dans le contexte de

l’arithmétique des intervalles réels. Le modèle des itérations

chaotiques a aussi servi de cadre à [ Fages et al. 1998] pour

des CSP dynamiques, dans les preuves de terminaisons d’exécutions

d’opérateurs.

Dans un premier temps, nous présenterons le contexte, ou plutôt ce

qui servira de support mathématique à la résolution et ses liens

avec le modèle CSP traditionnel. Puis, nous verrons comment un

algorithme générique peut s’écrire dans cette structure. Nous

finirons en présentant les finalités de ce cadre, à savoir des

propriétés de convergence.

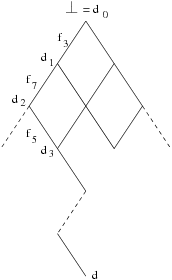

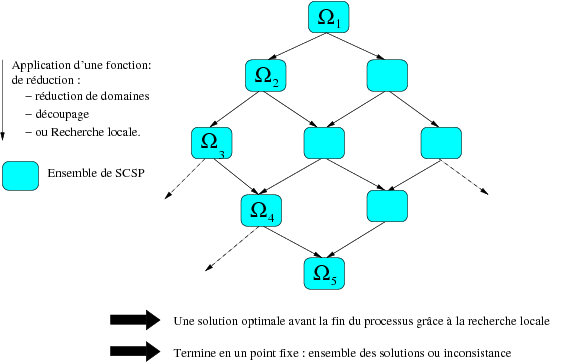

5.2 Ordre partiel

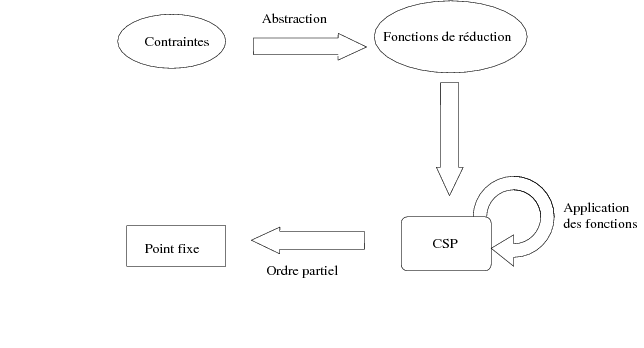

L’objectif du cadre défini par Apt, se servant de la notion d’ordre partiel, est de définir un ensemble de fonctions capables de converger vers un point fixe. En effet, la recherche des solutions, le processus de résolution est englobé dans une structure ordonnée. La figure 5.1 schématise le cadre de résolution, nous y retrouvons les contraintes, celles-ci sont décrites sous forme d’opérateurs de réduction (fonctions de réduction). Les fonctions sont appliquées sur le problème modélisé en CSP et l’application de ces fonctions correspond en réalité à une succession de réductions dans un ordre partiel.

- réflexive si (x,x) ∈ R pour tous x de D,

- irréflexive si (x,x) ∉ R pout tous x de D,

- antisymétrique si quelques soient x,y ∈ D on a (x,y) ∈ R et (y,x) ∈ R alors x=y,

- transitive si pour tous x,y,z ∈ D on (x,y) ∈ R et (y,z) R alors on a aussi (x,z) ∈ R.

5.3 Fonctions et propriétés

L’ordre partiel constitue ici le support de calcul pour les

fonctions que nous utiliserons. Mais pour obtenir un point fixe,

et afin d’établir une certaine cohérence dans les mécanismes en

jeu, des propriétés fondamentales sur ces fonctions sont

nécessaires.

Définition 16

Soit un ordre partiel (D,\sqsubseteq) et une fonction f sur D.

- f est dite inflationnaire si x \sqsubseteq f(x) pour tout x.

- f est dite monotone si x \sqsubseteq y implique que f(x) \sqsubseteq f(y) pour tous x,y.

Soit un ensemble D, un élément d ∈ D et un ensemble de fonctions F = { f1,...,fk} portant sur D.

- une exécution (de fonctions f1,...,fk) correspond à une séquence infinie de nombre de [1..k].

- une exécution i1,i2,... est dite équitable si tout i ∈ [1..k] apparaît une infinité de fois.

- Une itération de F est définie comme une de valeurs d0,d1,d2...induite par :

d0 = ⊥. avec ij ∈ [1..k].

dj = fij(dj-1). - On a une suite croissante d0 \sqsubseteq d1 \sqsubseteq d2 ... d’éléments de D qui peut se stabiliser en d si pour j ≥ 0 on a di = d pour i ≥ j.

|